A partir de este curso 2013-2014 el IES Arquitecto Ventura Rodríguez es un centro certificador de Zentyal. El módulo formativo de Servicios en Red de nuestro Ciclo Formativo SMR permite incluir totalmente Zentyal en la programación anual. De esta forma aquellos alumnos que lo deseen podrán certificarse en Zentyal también.

A partir de este curso 2013-2014 el IES Arquitecto Ventura Rodríguez es un centro certificador de Zentyal. El módulo formativo de Servicios en Red de nuestro Ciclo Formativo SMR permite incluir totalmente Zentyal en la programación anual. De esta forma aquellos alumnos que lo deseen podrán certificarse en Zentyal también.

Etiqueta: Redes

Hacking y anonimato, para pasar un buen rato

Cómo instalar el controlador inalámbrico en Ubuntu 12.xx

No sé como un día perdí la conexión wifi de mi máquina en la que tenía instalado un Ubuntu 12.10, después de mirar las conexiones de red y comprobar que tenía perfectamente configurada mi wifi seguía sin conexión, era evidente que por algún motivo mi sistema no reconocía adaptador wifi.

De modo que me dispuse a instalar de nuevo los drivers controladores y esto es lo que hice y aquí lo dejo para quien le pueda servir:

Te diriges al menú y seleccionas Centro de Software de Ubuntu y buscas Controladores Adicionales descargas e instalas

Seleccionas el driver controlador a instalar, lo instalas y listo, seguro que ya vuelves a tener la conexión inalámbrica

Controlar tu Pc desde tu móvil

Es muy sencillo y además es una aplicación gratuita para uso no comercial, Software Libre. Se llama Teamviewer.

Lo tenéis todos a vuestra disposición. De momento yo lo he usado entre mi android (móvil) y mi PC (Ubuntu) y me funciona perfectamente.

¿Para qué sirve?. Pues para acceder de forma lejana y remota a tu PC, si dispones de un móvil con pantalla grandecita te puede facilitar mucho la vida.

¿Cómo funciona?, Pues le haces una instalación en móvil y otra en el PC. Cuando lo tienes en el ordenador te proporcionará un identificador y contraseña por las que accedes desde el terminal móvil. Verás que el cursor lo puedes arrastrar directamente en la pantalla con el dedo.

¿Cómo lo hacemos?

En el móvíl haces la descarga desde PlayStore, en el PC haces la descarga y pides abrir desde el Centro de Software de Ubuntu, serán una de las opciones que te indicará una vez finalizada la descarga. Instalas la aplicación por esta vía, es decir, por el Centro de Sw de Ubuntu y lanzas la aplicación.

Una vez que la has lanzado te proporcionará un identificacdor y una pasaword, que son las que debes usar desde el móvil par realizar la conexión.

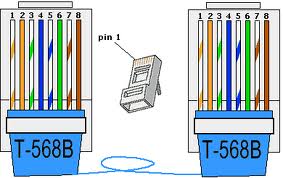

Cable UTP sólo usa 4 hilos

Todos conocemos el famoso cable UTP , son hilos cruzados de dos en dos con la gama de colores, blanco-naranja, naranja, blanco-verde, verde, blanco-azul, azul, blanco marrón, marrón. Para realizar el montaje de conectores rj45 sobre ellos debemos destrenzar.

, son hilos cruzados de dos en dos con la gama de colores, blanco-naranja, naranja, blanco-verde, verde, blanco-azul, azul, blanco marrón, marrón. Para realizar el montaje de conectores rj45 sobre ellos debemos destrenzar.

Una vez alisado y destrenzado colocamos siguiendo la norma T-568B o T-568A.

En cualquier caso sabemos que de esos 8 hilos sólo vamos a usar 4, que son exactamente 1,2,3 y 6, dos de ellos para emitir y dos de ellos para recibir.

La pregunta que nos hacemos continuamente es: ¿para qué se usan los otros 4?, y si no se usan, ¿por qué existen?

La pregunta que nos hacemos continuamente es: ¿para qué se usan los otros 4?, y si no se usan, ¿por qué existen?

Pues la respuesta creo tenerla después de consultar la red y de leerme muchos foros.

Parece ser que en los orígenes, se reservaron los hilos Blanco-Azul, Azul para telefonía analógica y el Blanco-Marrón, Marrón para telefonía digital.

Lo cierto es que actualmente sólo usamos los 4 indicados anteriormente.

Si nos fijamos detenidamente, en la norma 568B los hilos 1,2,3,6, correponden a los colores Blanco-Naranja(1), Naranja(2), Blanco-Verde(3), Verde(6). Quedando liberados los colores Blanco-Azul, Azul y Blanco-Marrón, Marrón.

Después de publicar hasta aquí, me indica @fustero en twitter: «como curiosidad para tener 1G con utp cat. 5e se usan los 4 pares. Con cat. 6 se vuelven a usar solo 2 pares»

Busco en wikipedia y dice:

«Como el cable Cat 5e puede transportar, de forma fiable, hasta 125 Mbps de tráfico, obtener 1000 Mbps (Gigabit) de ancho de banda fue un desafío de diseño. El primer paso para lograr una 1000BASE-T es utilizar los cuatro pares de hilos en lugar de los dos pares tradicionales utilizados para 10BASE-T y 100BASE-TX. Esto se logra mediante un sistema de circuitos complejo que permite las transmisiones full duplex en el mismo par de hilos. Esto proporciona 250 Mbps por par. Con los cuatro pares de hilos, proporciona los 1000 Mbps esperados. Como la información viaja simultáneamente a través de las cuatro rutas, el sistema de circuitos tiene que dividir las tramas en el transmisor y reensamblarlas en el receptor»

Con lo que queda confirmado lo que dice @fustero

La red Aloha

Fue creada en la Universidad de Hawai en 1970, con el presupueto de DARPA, es decir, el Ministerio de Defensa de EEUU. Vamos, los mismos que subvencionaron ARPAnet, la precursora de nuestra actual Internet.

Fue creada en la Universidad de Hawai en 1970, con el presupueto de DARPA, es decir, el Ministerio de Defensa de EEUU. Vamos, los mismos que subvencionaron ARPAnet, la precursora de nuestra actual Internet.

La red Aloha se crea bajo la necesidad de comunicar diferentes centros de Investigación situados en diferentes islas del archipiélago polinesio.

¿Qué es lo novedoso en aquel momento?. Pues que en vez de usar cable usaron un medio inalámbrico, es decir las ondas de radio. Además todos ellos estaban transmitiendo y recibiendo en las mismas frecuencias, lo que hacía que todos escucharan lo que uno de ello transmitía.

En definitiva es el origen del protocolo CSMA/CD y por tanto, los orígenes de nuestra manida ETHERNET (IEE 802.3).

Taller sobre instalación de un patch panel

Llevamos varios días trabajando sobre la instalación física de una red local. Hemos realizado latiguillos UTP, normales y cruzados. Hemos realizado el montaje de hembras y hoy teníamos que engastar los patch panel, para comprender la organización y estructura de un cableado.

Una vez terminado debíamos ubicar correctamente en el rack.

|

| taller de redes |

Qué es «cloud computing»

La traducción sería computación en la nube, o algo así, lo cierto es que cada vez que nos referimos a la nube estamos hablando de Internet.

En realidad nos están vendiendo un servicio más de Internet, pero sería intersante saber en qué consiste. Lo primero sería mencionar que el almacenamiento de los datos quedaría en manos de los proveedores, esto ya hace disparar todas nuestras alarmas.

Se supone que la nube nos ofrece web os + datos + aplicaciones, es decir necesitaríamos un mínimo hardware puesto que todo nuestro software descansaría en la red.

Críticas

- El London Times compara la computación en nube con los sistemas centralizados de los años 50 y 60, en los que los usuarios se conectaban a través de terminales «tontos» con ordenadores centrales. Generalmente, los usuarios no tenían libertad para instalar nuevas aplicaciones, y necesitaban la aprobación de administradores para desempeñar determinadas tareas. En suma, se limitaba tanto la libertad como la creatividad. El Times argumenta que la computación en nube es un retorno a esa época.

- De forma similar, Richard Stallman, fundador de la Free Software Foundation, cree que la computación en nube pone en peligro las libertades de los usuarios, porque éstos dejan su privacidad y datos personales en manos de terceros. “Una de las razones por las que no debes usar aplicaciones web para tus tareas de TI, es que pierdes el control. Tú debes estar en condiciones de realizar tus propias tareas en tu propio PC, en un programa amante de la libertad. Si usas un programa propiedad de un proveedor, o el servidor Web de otra persona, entonces quedas indefenso…el cloud computing es una trampa”.

- “el cloud computing es la verdadera batalla importante en este momento en la escena tecnológica: las compañías que dominen “la nube” serán los verdaderos actores del futuro, con esquemas de concentración muy importantes debido a la misma naturaleza de la actividad”. Hugh Mcleod

Seguridad

Lo cierto es que la clave está en la solvencia que ofrezca el servidor.

Como en cualquier otro modelo, es importante tener en cuenta la seguridad y la continuidad del servicio. La seguridad en Cloud Computing debe ser analizada en función del modelo de Cloud que consideremos. Por ejemplo, si se opta por usar Clouds Públicos es necesario contar con un proveedor que ofrezca garantías de seguridad avanzada, ya que los datos residirán en un entorno controlado por un tercero y compartido con otras empresas».

Protección de la información: Se comparten recursos pero esto no puedo ir en menoscabo de la confidencialidad de los datos del cliente, que deberá estar garantizada en todo momento.

Recuperación: Desconocer la localización de la información no puede implicar jamás que no existan las medidas necesarias de seguridad y replicación para garantizar su recuperación en caso de desastre o pérdida de los mismos.

Una relación ‘para toda la vida’: La sostenibilidad del proveedor tiene que estar garantizada. Fusiones, quiebras, cualquier cambio en su negocio no puede dejar ‘indefenso’ al cliente y, por ello, se establecerá un compromiso de continuidad a largo plazo en la relación en los propios términos del contrato.

Problemas de seguridad en IPv6

La charla que he recibido hoy en el curso de Seguridad Informática, Ataques Man in the Middle en iPv6: Juan Luis G. Rambla, me ha dejado bastante impresionada es por ello que quiero dejaros un enlace a un blog en el que explica parte de esta idea ,

http://blog.derecho-informatico.org/empiezan-los-problemas-de-seguridad-en-ipv6/2011/04/07/

Redes Wifi, cómo hemos cambiado

¿Cómo han proliferado las wifi en los últimos años?. Lo que hace 7 años parecía una nueva tecnología de última genaración ahora es una forma natural de comunicación en muchos ámbitos.

Desde un primer momento se vislumbró que iba a tener una especial acogida en los hogares, privarnos del engorro del cable, era una razón más que suficiente.

Además, la proliferación de portátiles y ultraportátiles, las pda, los móviles y todo tipo de dispositivos que iban apareciendo en nuestras viviendas han hecho de las wifi una necesidad más, como el frigorífico o la lavadora.

Recuerdo que en 2004 comenzabas a detectar wifis y con un poco de suerte detectabas un par de ellas, ahora detectamos 10 ó 12 de un primer vistazo.

Otra diferencia es que hace unos años casi todas estaban abiertas (no seguras) porque así venían configuradas desde el proveedor, y tenía un morbo especial navegar un ratito con la wifi del vecino, te sentías un poco hacker. Ahora todas son «seguras» y los proveedores les ponen una contraseñas de 20 caracteres, imposibles de recordar.

Lo más curioso es que ahora son los hackers quienes tienen abiertas sus wifis como anzuelo para que entres en sus redes y poderte devorar. ¿Cómo hemos cambiado?

Todo esto parece que lo tenemos controlado, pero aún tengo dudas de si la gente sabe qué hacer con la wifi de casa, me explico:

Hacia 2004 disponíamos de wifis 802.11b, a 11 Mbps, ¿qué quiere decir esto?, pues es esto significa que del router para dentro (hacia tu morada) tenías esa velocidad, si tienes 2 equipos informáticos, divides el ancho de banda entre ambos, y esa es la velocidad a la que se pueden comunicar estos dos equipos. ¿Para qué?, para transmitirse archivos.

Posteriormente, surgieron las wifis 802.11g, a 54 Mbps, y entonces habíamos aumentado la velocidad de transmisión entre los equipos de casa.

Ahora presumimos de nuestrs 802.11n, 600 Mbps, esto es un salto de campeones, sin lugar a dudas.

Claro, tener una 802.11n es importante si tienes organizada la red de tu vivienda, es decir, compartes impresora, pelis entre los ordenadores, fotografías, música, pero si te sigues trasladando con el pendrive de un ordenador a otro de tu casa es que no has entendido para qué necesitas el router 802.11n.

Esa es la ventaja porque salir a Internet, casi seguro que no sales a más de 11Mbps con lo que las primeras wifi era casi suficiente.